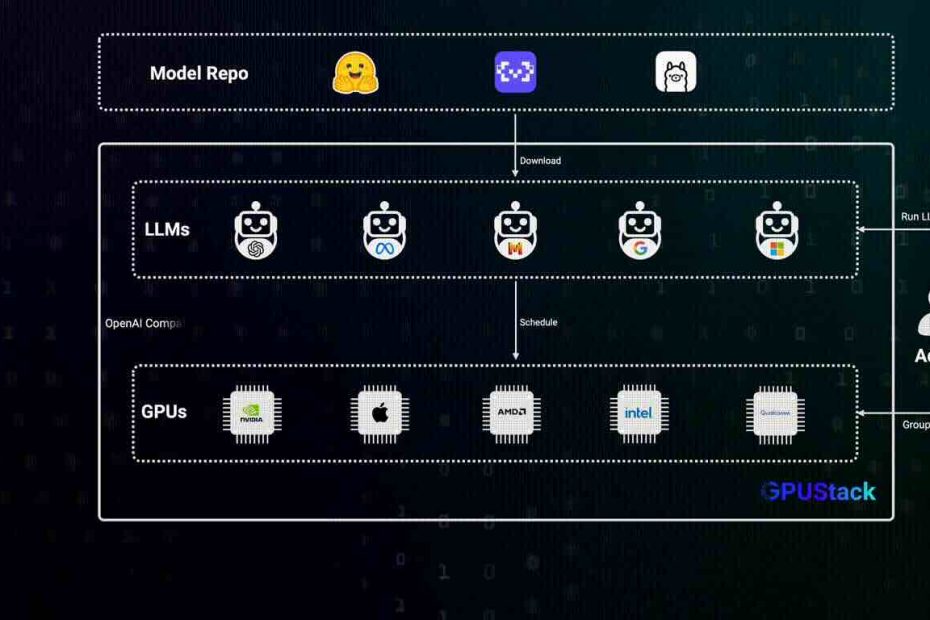

GPUStack adalah manajer klaster GPU sumber terbuka yang dirancang untuk menjalankan model kecerdasan buatan (AI). Aplikasi ini menyediakan cara yang fleksibel dan skalabel untuk memanfaatkan sumber daya GPU, mendukung berbagai kartu grafis dan jenis model.

Fitur Utama GPUStack

GPUStack menawarkan serangkaian fitur yang kuat untuk pengelolaan dan penerapan model AI. Pertama, ia memiliki Kompatibilitas GPU yang Luas, yang berarti dapat bekerja dengan GPU dari berbagai produsen, termasuk NVIDIA, AMD, Apple (chip M-series), dan lainnya. Ini memastikan pengguna dapat memanfaatkan perangkat keras yang sudah ada.

Fitur penting lainnya adalah Dukungan Model yang Ekstensif. GPUStack mampu menjalankan berbagai jenis model AI, mulai dari model bahasa besar (LLM), model visi-bahasa (VLM), model gambar, model audio, hingga model embedding dan rerank. Ini mencakup model-model populer seperti Qwen, LLaMA, Mistral, dan Stable Diffusion.

GPUStack juga menyediakan Backend Inferensi yang Fleksibel. Aplikasi ini terintegrasi dengan berbagai backend inferensi seperti vLLM, Ascend MindIE, llama-box (yang mencakup llama.cpp dan stable-diffusion.cpp), serta vox-box. Keunikan lainnya adalah Dukungan Backend Multi-Versi, yang memungkinkan berbagai versi backend inferensi berjalan bersamaan. Ini sangat berguna untuk model yang memiliki persyaratan runtime yang berbeda.

Untuk performa tinggi, GPUStack mendukung Inferensi Terdistribusi, baik pada satu node maupun multi-node dengan multi-GPU. Ini termasuk kemampuan untuk menggunakan GPU heterogen dari berbagai vendor dan lingkungan runtime. Arsitektur GPU yang Skalabel memungkinkan pengguna untuk dengan mudah menambah lebih banyak GPU atau node ke infrastruktur mereka seiring kebutuhan.

Stabilitas adalah prioritas, dan GPUStack memastikan Stabilitas Model yang Kuat dengan fitur pemulihan kegagalan otomatis, redundansi multi-instans, dan penyeimbangan beban untuk permintaan inferensi. Sebelum menerapkan model, ada Evaluasi Penerapan yang Cerdas yang secara otomatis menilai persyaratan sumber daya model, kompatibilitas backend dan arsitektur, serta kompatibilitas sistem operasi.

GPUStack juga dilengkapi dengan Penjadwalan Otomatis yang secara dinamis mengalokasikan model berdasarkan sumber daya yang tersedia. Sebagai paket Python yang Ringan, ia memiliki ketergantungan minimal dan overhead operasional yang rendah.

Untuk kemudahan integrasi, GPUStack menyediakan API yang Kompatibel dengan OpenAI, yang sepenuhnya sesuai dengan spesifikasi API OpenAI. Ini memungkinkan integrasi yang mulus dengan alat dan alur kerja yang sudah ada. Fitur Manajemen Pengguna & Kunci API yang disederhanakan membantu dalam mengelola akses.

Terakhir, GPUStack menawarkan Pemantauan GPU Real-Time untuk melacak kinerja dan pemanfaatan GPU, serta Metrik Token dan Tingkat untuk memantau penggunaan token dan tingkat permintaan API.

Instalasi GPUStack di Ubuntu untuk NVIDIA GPU

Untuk menginstal GPUStack di sistem Ubuntu dengan tiga GPU NVIDIA 1060 Super, Anda perlu memastikan beberapa prasyarat terpenuhi.

Prasyarat

Sebelum memulai, pastikan sistem Anda telah memenuhi prasyarat berikut:

- Sistem Operasi Ubuntu: Pastikan Anda menggunakan Ubuntu sebagai sistem operasi Anda.

- Driver NVIDIA: Instal driver NVIDIA terbaru yang sesuai untuk kartu grafis NVIDIA 1060 Super Anda. Anda bisa memeriksanya dengan perintah nvidia-smi.

- Docker: Instal Docker pada sistem Ubuntu Anda. Docker adalah platform containerization yang akan digunakan GPUStack untuk menjalankan layanannya. Anda dapat mengikuti panduan instalasi resmi Docker dari dokumentasi Docker.

- NVIDIA Container Toolkit: Setelah Docker terinstal, Anda perlu menginstal NVIDIA Container Toolkit. Ini memungkinkan kontainer Docker untuk mengakses GPU NVIDIA Anda. Panduan instalasinya juga tersedia di situs web NVIDIA Container Toolkit.

Langkah-langkah Instalasi

Setelah semua prasyarat terpenuhi, Anda dapat memulai server GPUStack dengan satu perintah Docker.

Jalankan Perintah Docker: Buka terminal dan jalankan perintah berikut:

docker run -d --name gpustack \ --restart=unless-stopped \ --gpus all \ --network=host \ --ipc=host \ -v gpustack-data:/var/lib/gpustack \ gpustack/gpustack Penjelasan perintah ini:

Ambil Kata Sandi Admin: Setelah server GPUStack berjalan, Anda perlu mendapatkan kata sandi admin awal untuk masuk ke antarmuka pengguna (UI). Jalankan perintah berikut di terminal:

docker exec gpustack cat /var/lib/gpustack/initial_admin_password Perintah ini akan menampilkan kata sandi di terminal. Salin dan simpan kata sandi ini.

Akses Antarmuka Pengguna (UI): Buka browser web Anda dan navigasikan ke http://your_host_ip. Ganti your_host_ip dengan alamat IP aktual dari mesin Ubuntu Anda.

Saat diminta, gunakan nama pengguna admin dan kata sandi yang Anda ambil pada langkah sebelumnya untuk masuk.

Selamat, GPUStack Anda sekarang telah berhasil diinstal dan berjalan di sistem Ubuntu Anda!

Penerapan Model AI dengan GPUStack

Setelah GPUStack terinstal dan Anda berhasil masuk ke UI, langkah selanjutnya adalah menerapkan model AI. Prosesnya dirancang agar intuitif.

Menerapkan Model dari Katalog

- Navigasi ke Halaman Katalog: Di UI GPUStack, klik pada menu “Catalog” di bilah navigasi. Halaman ini akan menampilkan daftar model AI yang tersedia untuk diterapkan.

- Pilih Model: Dari daftar model yang tersedia, pilih model yang ingin Anda terapkan. Sebagai contoh, kita akan menggunakan model Qwen3. Klik pada model Qwen3.

- Periksa Kompatibilitas: GPUStack akan secara otomatis menjalankan pemeriksaan kompatibilitas untuk memastikan model dapat diterapkan pada infrastruktur GPU Anda. Setelah pemeriksaan ini berhasil, Anda akan melihat indikasi bahwa model kompatibel.

- Simpan untuk Menerapkan: Klik tombol “Save” untuk memulai proses penerapan model.

GPUStack akan mulai mengunduh file model dan memulai proses penerapan. Anda dapat memantau status penerapan di UI. Ketika status penerapan menunjukkan “Running”, berarti model telah berhasil diterapkan dan siap digunakan.

Menggunakan Model yang Diterapkan

Setelah model berhasil diterapkan, Anda dapat langsung menggunakannya melalui playground UI atau melalui API yang kompatibel dengan OpenAI.

Melalui UI Playground:

Klik “Playground – Chat” di menu navigasi.

Pastikan model qwen3 telah terpilih dari dropdown “Model” di pojok kanan atas.

Anda sekarang dapat mulai berinteraksi dengan model, misalnya dengan mengetikkan pertanyaan atau perintah.

Melalui API (Kompatibel dengan OpenAI):

Buat Kunci API: Arahkan kursor ke avatar pengguna Anda di UI dan navigasikan ke halaman “API Keys”.

Klik tombol “New API Key”.

Isi “Name” untuk kunci API Anda dan klik “Save”.

Kunci API akan dibuat dan ditampilkan sekali saja. Salin kunci ini dan simpan di tempat yang aman karena Anda tidak akan bisa melihatnya lagi setelah halaman ditutup.

Gunakan Kunci API: Anda sekarang dapat menggunakan kunci API ini untuk mengakses endpoint API yang kompatibel dengan OpenAI yang disediakan oleh GPUStack. Contoh penggunaan dengan curl:

# Ganti `your_api_key` dan `your_gpustack_server_url` # dengan kunci API dan URL server GPUStack Anda yang sebenarnya. export GPUSTACK_API_KEY=your_api_key curl http://your_gpustack_server_url/v1/chat/completions \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $GPUSTACK_API_KEY" \ -d '{ "model": "qwen3", "messages": [ { "role": "system", "content": "You are a helpful assistant." }, { "role": "user", "content": "Tell me a joke." } ], "stream": true }'Penggunaan dengan Library Python OpenAI Resmi: Anda juga dapat menggunakan library OpenAI Python resmi untuk berinteraksi dengan API GPUStack:

from openai import OpenAI client = OpenAI(base_url="http://your_gpustack_server_url/v1-openai", api_key="your_api_key") completion = client.chat.completions.create( model="llama3.2", messages=[ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "Hello!"} ] ) print(completion.choices[0].message) Pastikan untuk mengganti your_gpustack_server_url dan your_api_key dengan nilai yang benar.

Platform dan Akselerator yang Didukung

GPUStack dirancang untuk fleksibilitas dan mendukung berbagai platform dan akselerator perangkat keras.

Platform yang Didukung

- Linux: Ini termasuk distribusi seperti Ubuntu, CentOS, dan lainnya.

- macOS: Mendukung perangkat Mac dengan chip M-series.

- Windows: Tersedia installer desktop untuk sistem operasi Windows.

Akselerator yang Didukung

GPUStack kompatibel dengan berbagai akselerator GPU, memastikan pengguna dapat memanfaatkan berbagai hardware yang berbeda:

- NVIDIA CUDA: Mendukung GPU NVIDIA dengan kemampuan komputasi 6.0 ke atas, yang mencakup NVIDIA 1060 Super Anda.

- Apple Metal: Kompatibel dengan chip M-series Apple.

- AMD ROCm: Dukungan untuk GPU AMD.

- Ascend CANN: Mendukung akselerator Ascend.

- Hygon DTK: Kompatibel dengan akselerator Hygon.

- Moore Threads MUSA: Dukungan untuk GPU Moore Threads.

- Iluvatar Corex: Mendukung akselerator Iluvatar.

- Cambricon MLU: Kompatibel dengan akselerator Cambricon.

Model yang Didukung

GPUStack memanfaatkan berbagai backend inferensi seperti vLLM, Ascend MindIE, llama-box (dengan llama.cpp dan stable-diffusion.cpp), serta vox-box. Ini memungkinkannya mendukung berbagai model dari berbagai sumber, termasuk Hugging Face, ModelScope, dan jalur file lokal.

Kategori Model dan Contoh

Berikut adalah beberapa kategori model yang didukung GPUStack beserta contohnya:

- Large Language Models (LLMs): Qwen, LLaMA, Mistral, DeepSeek, Phi, Gemma.

- Vision Language Models (VLMs): Llama3.2-Vision, Pixtral, Qwen2.5-VL, LLaVA, InternVL3.

- Diffusion Models: Stable Diffusion, FLUX.

- Embedding Models: BGE, BCE, Jina, Qwen3-Embedding.

- Reranker Models: BGE, BCE, Jina, Qwen3-Reranker.

- Audio Models: Whisper (Speech-to-Text), CosyVoice (Text-to-Speech).

Untuk daftar lengkap model yang didukung, Anda dapat merujuk ke bagian model yang didukung di dokumentasi backend inferensi resmi GPUStack.

API yang Kompatibel dengan OpenAI

GPUStack menyediakan endpoint API yang sepenuhnya kompatibel dengan OpenAI di bawah jalur /v1-openai. Ini berarti Anda dapat menggunakan library dan alat yang dirancang untuk OpenAI untuk berinteraksi dengan model yang diterapkan di GPUStack. API yang didukung meliputi:

- Daftar Model

- Buat Completion (Penyelesaian Teks)

- Buat Chat Completion (Penyelesaian Obrolan)

- Buat Embeddings

- Buat Gambar

- Buat Edit Gambar

- Buat Pidato (Text-to-Speech)

- Buat Transkripsi (Speech-to-Text)

Kemampuan ini memungkinkan pengembang untuk dengan mudah mengintegrasikan model AI yang berjalan di GPUStack ke dalam aplikasi mereka tanpa perlu mengubah banyak kode jika mereka sudah terbiasa dengan API OpenAI. Pengguna GPUStack dapat menghasilkan kunci API mereka sendiri melalui UI untuk mengamankan akses ke layanan ini.

Dokumentasi dan Pembuatan

Untuk informasi lebih lanjut dan dokumentasi lengkap, Anda dapat mengunjungi situs dokumentasi resmi GPUStack.

Jika Anda ingin membangun GPUStack dari sumbernya, Anda dapat mengikuti langkah-langkah berikut:

- Instal Python: Pastikan Anda memiliki Python versi 3.10 hingga 3.12 terinstal di sistem Anda.

- Jalankan make build: Buka terminal dan jalankan perintah make build.

- Temukan Paket wheel: Setelah proses build selesai, Anda akan menemukan paket wheel yang telah dibangun di direktori dist.

Sumber: Github